Schnittstelle von Kunst und Technologie : Wie Sensoren kooperative Kunst im Ars Electronica Center ermöglichen

Das Ziel von pharus ist es, einer beliebig großen Gruppe von Personen in nahezu jeder Umgebung Interaktionsmöglichkeiten zu bieten.

- © Ars Electronica – Robert BauernhanslDie Forschung im Ars Electronica FutureLab betrachtet die sozialen Aspekte technologischer Entwicklungen und die Auswirkungen auf die Zukunft der Gesellschaft. Dazu werden künstliche Intelligenz, Robotik, Interaktion, Kunst und Schwarmintelligenz kombiniert. Damit diese Verbindung funktioniert, kommen Sensoren zum Einsatz.

In der Forschung spricht man bei der Beobachtung des Zusammenspiels von Gruppen und Maschinen von „Crowd Computer Interaction“. Auch das FutureLab setzt auf solche Interaktionen mit den Besucher*innen, um die Auswirkungen des eigenen Verhaltens sowie Technik begreifbar zu machen. Das Tracking-System „pharus“ (lat.: Leuchtturm), entwickelt vom Forscher und Künstler Otto Naderer, ermöglicht es einer beliebig großen Gruppe von Personen, in fast jeder Umgebung mit dem Umfeld zu interagieren.

Lesetipp: Neuer 2D-Vision-Sensor mit KI

Um erkannt zu werden, müssen die Personen keine Tags oder Geräte bei sich tragen. Sie werden von den Sick LiDAR-Sensoren LMS100 erfasst, sobald sie den überwachten Bereich betreten. Diese sind rund um eine Interaktionsfläche in Knöchelhohe angebracht. Durch die unterschiedlichen Perspektiven der Sensoren werden selbst Personen, die etwa hintereinanderstehen, identifiziert.

Koexistenz von Mensch und Maschine

Diese Messdaten aller Sensoren, auch „Echos“ genannt, werden überlagert und ausgewertet. Effekte der gegenseitigen Abschirmung werden kompensiert. Wenn ein oder mehrere Sensoren die Sichtlinie verlieren, können andere die zu verfolgende Person oder das Objekt „übernehmen“. Sollten alle Sensoren die Spur verlieren, kann pharus den Verlauf der Bewegung für eine gewisse Zeit vorhersagen und so Ausfälle verhindern. Das eröffnet spannende Möglichkeiten. Aktuell wird die Eignung der Software für den Einsatz auf mobilen Plattformen geprüft und im Rahmen des Forschungsprojekts „Cobot Studio“ wird daran gearbeitet, die Koexistenz von Mensch und Maschine zu optimieren.

In der „Game Changer Suite“ können mehrere Personen – repräsentiert durch virtuelle Avatare – mit vollem Körpereinsatz in verschiedensten Szenarien gegeneinander antreten. Sie lädt Besucher*innen dazu ein, aus einer Reihe von rasanten und agilen Minispielen zu wählen, um selbst zu erfahren, welche Möglichkeiten das System bietet, und wie es sich anfühlt, digital “getrackt” zu sein.

Kooperative Ästhetik

Weniger Verspielte können die eigene künstlerische Seite ausleben, indem sie sich durch einen Raum bewegen und durch die Bewegungsmuster gemeinsam Bilder erschaffen. Studiengangsleiter Univ.Prof. Gerhard Funk von der Kunstuniversität Linz nennt dies „kooperative Ästhetik“. Ihm geht es darum, einen Raum zu schaffen, in dem eine Handlung direkt erfahrbar und ersichtlich wird – ganz im Sinne des Ars Electronica Centers.

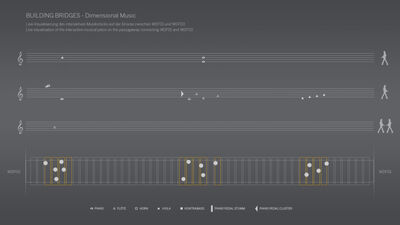

Durch den Kontakt mit anderen können die Besucher*innen dann gemeinsam ein ästhetisches Erlebnis entstehen lassen.Damit die Verbindungsbrücke zweier Gebäude des SAP Walldorf-Campus musikalisch wird, hat das SAP-Orchester zunächst einzelne Töne eingespielt. Betritt jemand die Brücke, werden die Bewegungen mittels „pharus“ und den LiDAR-Sensoren erfasst und die jeweiligen Töne dann über Lautsprecher abgespielt. Bei hohem Aufkommen entsteht so jedes Mal eine komplett individuelle Klangkomposition – das interaktive Musikstück „Building Bridges“.